Spis treści

Opis przypadku

Google nie wspomina na stronach Pomocy o konieczności posiadania pliku robots.txt:

Nie jest to mechanizm służący do ukrywania strony internetowej przed Google

dodając, że można go utworzyć

jeśli uważasz, że go potrzebujesz.

Jednak z mojego doświadczenia powiem, że warto go posiadać nawet wtedy, gdy zawierać będzie tylko domyślne ustawienie, czyli

User-Agent: *

Disallow:

Allow: /

lub

User-Agent: *

Disallow:

Disallow:

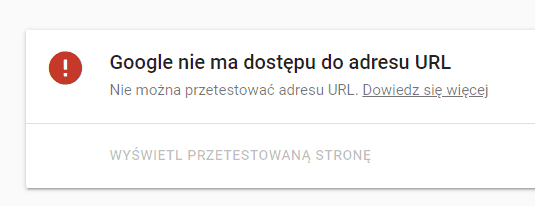

Inaczej może się okazać, że np. nasz system wygeneruje „sztuczny plik”, do którego nie posiadają dostępu roboty indeksujące

W takiej sytuacji Googlebot nie będzie w stanie zapoznać się z jego zawartością (test mobilny nie zostanie zaliczony)

przez co strona zniknie z wyników wyszukiwania.

Jak rozwiązać problem

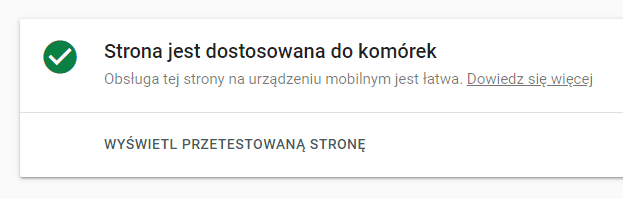

Na szczęście jest to stosunkowo proste – stworzenie pliku robots.txt z domyślną zawartością sprawia, że strona zaczyna przechodzić test mobilny

i wkrótce znowu pojawi się w wynikach wyszukiwania.

Konkluzja

Jeżeli nie chcesz mieć problemów z indeksowaniem przez Google treści na stronie stwórz pusty plik robots.txt, nawet, jak go nie potrzebujesz.

Link do dyskusji na Forum Pomocy Google dla Webmasterów.