Spis treści

Teoria

Komunikat „URL zablokowany przez plik robots.txt” ma miejsce np. wtedy, gdy zablokujemy daną stronę przez robotem indeksującym w pliku robots.txt, ale umieścimy ją w sitemapie (mapie witryny). Taka sytuacja jest sygnałem dla Googlebota, że właściciel strony chcę ją zaindeksować (dodał stronę do sitemapy), jednak nie jest to możliwe, ponieważ został zablokowany przed Googlebotem dostęp do niej w pliku robots.txt.

Jest to najczęściej związane z niedopatrzeniem i nieznajomością tego, jak działają systemy CMS. Np. WordPress domyślnie tworząc swoją sitemapę (dostępną pod adresem wp-sitemap.xml) dodaje do niej KAŻDĄ stronę. Jeżeli z jakiegoś powodu nie chcemy, aby jedna z nich była dostępna dla Googlebota i dodamy ją do pliku robots.txt, to w domyślnej instalacji nie zostanie ona usunięta z sitemapy. To z kolei oznacza, że Google, przemierzając plik sitemap.xml prędzej czy później ją odnajdzie. A ponieważ mapa witryny ma pomagać w jej indeksacji, informując roboty indeksujące wyszukiwarek o tym, że jej zawartość jest ważna dla właściciela strony i powinna znaleźć się w wynikach wyszukiwania, to Googlebot spróbuje to zrobić. Jednak z powodu zapisu w pliku robots.txt indeksacja nie będzie możliwe, więc Google wygeneruje właścicielowi strony w Search Console stosowne ostrzeżenie.

Rozwiązanie

W pierwszej kolejności sprawdzamy, czy dana strona faktycznie powinna zostać zaindeksowana.

Jeżeli nie, to odszukujemy ją (w CMSie/na serwerze), a następnie wchodzimy w edycję i dodajemy w jej nagłówku

<meta name=”robots” content=”noindex>

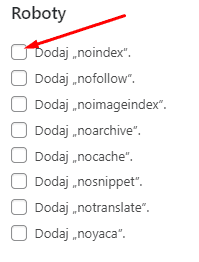

Jeżeli posiadamy WordPressa, możemy wykorzystać do tego jedną z wtyczek SEO. W swojej pracy używam do tego wtyczki Proste Ulepszenia SEO.

Po jej zainstalowaniu masz możliwość wykluczenia dowolnej strony z indeksacji: wystarczy wejść w edycję strony i zaznaczyć wskazany checkbox:

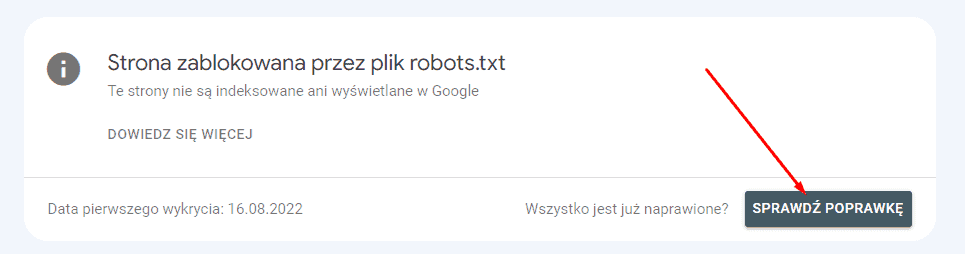

Jeżeli strona powinna jednak zostać zaindeksowana, to sprawdzamy ją testerem pliku robots.txt – np. tym od Google (wymagana jest weryfikacja usługi w Search Console). Może się bowiem zdarzyć, że Google zareagowało z opóźnieniem (dane w Search Console nie są aktualizowane na bieżąco) i pokazuje problem, który już nie istnieje.

Jeżeli tester poinformuje nas, że Googlebot może bez problemu wejść na stronę, to oznaczamy problem jako rozwiązany

i dajemy Google czas, aby zweryfikować stan danej strony.

Udanej analizy indeksacji Twojej strony 🙂